从脚本说起

在看源码之前,我们一般会看相关脚本了解其初始化信息以及Bootstrap类,Spark也不例外,而Spark我们启动三端使用的脚本如下:

%SPARK_HOME%/sbin/start-master.sh

%SPARK_HOME%/sbin/start-slaves.sh

%SPARK_HOME%/sbin/start-all.sh

%SPARK_HOME%/bin/spark-submit

三端启动脚本中对于公共处理部分进行抽取为独立的脚本,如下:

| spark-config.sh | 初始化环境变量 SPARK_CONF_DIR, PYTHONPATH |

| bin/load-spark-env.sh | 初始化环境变量SPARK_SCALA_VERSION, 调用%SPARK_HOME%/conf/spark-env.sh加载用户自定义环境变量 |

| conf/spark-env.sh | 用户自定义配置 |

接下来针对于一些重要的脚本进行一一描述

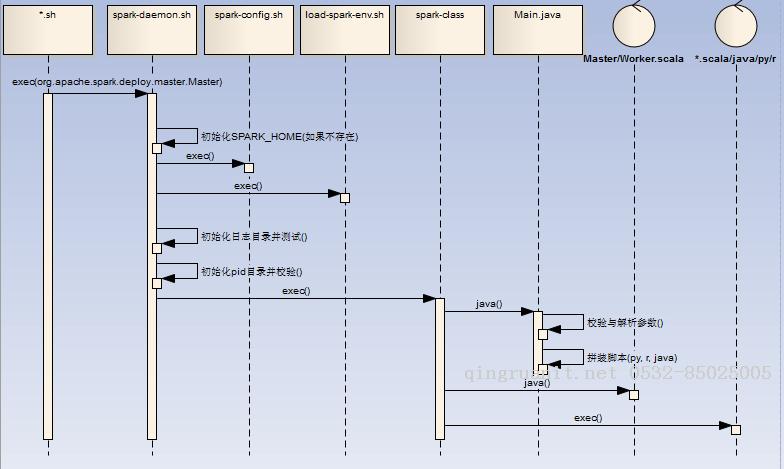

一. start-daemon.sh

主要完成进程相关基本信息初始化,然后调用bin/spark-class进行守护进程启动,该脚本是创建端点的通用脚本,三端各自脚本都会调用spark-daemon.sh脚本启动各自进程

初始化 SPRK_HOME,SPARK_CONF_DIR,SPARK_IDENT_STRING,SPARK_LOG_DIR环境变量(如果不存在)

初始化日志并测试日志文件夹读写权限,初始化PID目录并校验PID信息

调用/bin/spark-class脚本,/bin/spark-class见下

二. bin/spark-class

master调用举例:bin/spark-class --class org.apache.spark.deploy.master.Master --host $SPARK_MASTER_HOST --port $SPARK_MASTER_PORT --webui-port $SPARK_MASTER_WEBUI_PORT $ORIGINAL_ARGS

初始化 RUNNER(java),SPARK_JARS_DIR(%SPARK_HOME%/jars),LAUNCH_CLASSPATH信息

调用( "$RUNNER" -Xmx128m -cp "$LAUNCH_CLASSPATH" org.apache.spark.launcher.Main "$@")获取最终执行的shell语句